大家好,我是大师兄,今天想和大家分享一下我最近在数据分析领域的一个重要突破——回归树与提升树的学习心得。作为一个数据科学爱好者,我一直对机器学习算法充满好奇,尤其是那些能够帮助我们更好地理解和预测数据的模型。今天,我们就一起来探讨一下回归树与提升树的魅力吧。

一、初识回归树

回归树(Regression Tree)是决策树的一种变体,主要用于处理连续型目标变量的预测问题。它通过递归地将数据集划分为多个子集,最终形成一个树状结构。每个内部节点表示一个特征的分裂条件,而每个叶节点则包含一个预测值。

在学习回归树的过程中,我遇到了不少挑战。首先是如何选择合适的分裂点。回归树的目标是使每个子集内的数据尽可能同质化,即方差最小化。为了实现这一点,我尝试了多种分裂准则,如均方误差(MSE)、绝对误差(MAE)等。经过反复实验,我发现MSE在大多数情况下表现更好,尤其是在处理线性关系较强的数据时。

另一个难点是如何避免过拟合。回归树容易在训练数据上表现得过于完美,但在测试数据上却表现不佳。为了解决这个问题,我学习了剪枝技术(Pruning)。剪枝可以通过删除一些不必要的分支来简化树的结构,从而提高模型的泛化能力。常见的剪枝方法有预剪枝(Pre-pruning)和后剪枝(Post-pruning)。预剪枝是在构建树的过程中提前停止分裂,而后剪枝则是在树构建完成后进行修剪。通过实践,我发现后剪枝的效果通常更佳,因为它能够在保证模型复杂度的同时,保留更多的有用信息。

二、提升树的力量

在掌握了回归树的基本原理后,我开始接触提升树(Boosting Trees)。提升树是一种集成学习方法,它通过组合多个弱学习器(通常是简单的回归树)来构建一个强大的预测模型。与随机森林不同,提升树的核心思想是逐步修正前面模型的错误,从而使整体模型的性能不断提升。

最常见的提升树算法是梯度提升树(Gradient Boosting Tree, GBT)。GBT通过迭代的方式,每次生成一棵新的树来拟合前一轮模型的残差。具体来说,假设我们已经训练了k棵树,那么第k+1棵树的目标就是最小化当前模型的损失函数。为了实现这一点,GBT使用梯度下降法来优化模型参数,从而使得每棵树都能有效地修正前一轮的预测误差。

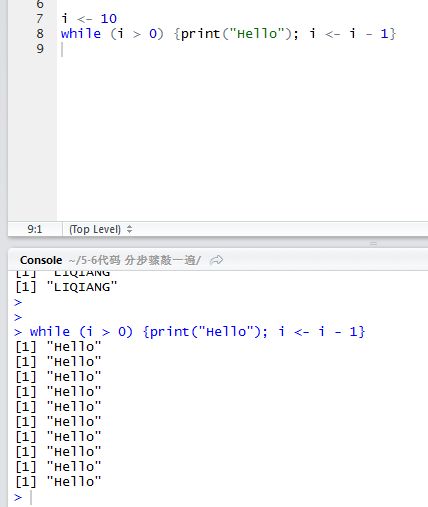

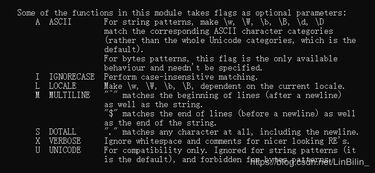

在实际应用中,我使用了Python中的scikit-learn库来实现梯度提升树。通过调整学习率(learning rate)、树的深度(max_depth)、树的数量(n_estimators)等超参数,我可以灵活地控制模型的复杂度和性能。例如,较小的学习率可以使模型更加稳定,但训练时间会相应增加;较大的树深度可以提高模型的表达能力,但也容易导致过拟合。因此,在实践中,我通常会通过交叉验证(Cross-validation)来寻找最优的超参数组合。

三、实战案例:房价预测

为了巩固所学知识,我决定用回归树和提升树来解决一个实际问题——房价预测。我选择了Kaggle上的一个经典数据集,该数据集包含了美国某城市的房屋销售记录,包括房屋面积、卧室数量、浴室数量、地理位置等多个特征。我的目标是根据这些特征预测房屋的售价。

首先,我使用回归树进行了初步建模。由于回归树的结构较为简单,模型的训练速度非常快。然而,我发现单棵回归树的预测效果并不理想,尤其是在处理复杂的非线性关系时。于是,我决定尝试提升树。通过构建多棵回归树并将其组合成一个提升树模型,我显著提高了预测的准确性。特别是在处理异常值和噪声数据时,提升树的表现尤为出色。

为了进一步优化模型,我还引入了一些特征工程技巧。例如,我通过对原始特征进行标准化处理,消除了不同特征之间的量纲差异;我还使用了多项式特征(Polynomial Features)来捕捉特征之间的交互效应。此外,我还尝试了L1正则化(Lasso)和L2正则化(Ridge)来防止模型过拟合。最终,我的提升树模型在测试集上的表现非常令人满意,预测误差明显低于单棵回归树。

四、总结与展望

通过这段时间的学习,我对回归树和提升树有了更深的理解。回归树作为一种简单而直观的模型,适合处理线性或近似线性的数据;而提升树则通过集成多棵树,能够更好地捕捉数据中的复杂模式。在未来的学习中,我计划继续探索其他类型的决策树模型,如随机森林、XGBoost等,并尝试将它们应用到更多的实际场景中。

如果你也对回归树和提升树感兴趣,欢迎留言交流!让我们一起在数据科学的道路上不断进步吧!

发表评论 取消回复