作为一名对计算机技术充满热情的探索者,我一直对GPU如何实现并行计算感到好奇。在知乎上看到这个话题成为热搜后,我决定深入研究一下,分享给大家。

一、什么是GPU?

大家都知道,CPU是计算机的大脑,负责处理各种任务。而GPU(图形处理器)最初是为了加速图形渲染而设计的。随着技术的发展,人们发现GPU不仅擅长处理图形,还能用于其他需要大量并行计算的任务,如机器学习、科学计算等。

二、为什么GPU适合并行计算?

与CPU不同,GPU拥有成千上万个小型处理单元,这些处理单元可以同时执行相同的操作。这使得GPU在处理大规模数据时表现出色。举个例子,如果你有一堆信件需要分类,一个人(CPU)可能需要花费很长时间才能完成,但如果有成千上万个小助手(GPU处理单元)一起工作,任务就能很快完成。

三、GPU并行计算的基本原理

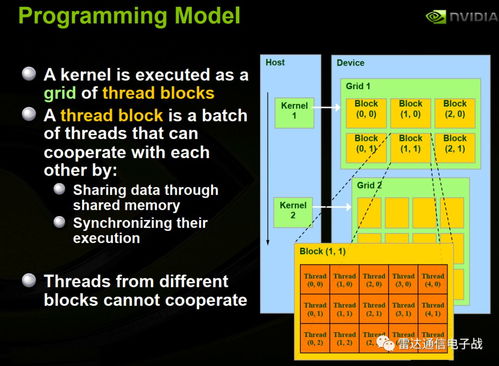

1. 线程组织结构

GPU中的线程被组织成不同的层次结构。最底层是线程束(Warp),每个线程束包含32个线程。多个线程束组成一个线程块(Block),而多个线程块又组成一个网格(Grid)。这种层次化的结构有助于高效地管理和调度线程。

2. 共享内存机制

为了提高数据访问速度,GPU提供了共享内存。同一线程块内的线程可以快速访问共享内存中的数据,减少了对外部内存的依赖。这就好比在一个团队中,成员们可以快速交流信息,提高了整体工作效率。

3. 指令级并行性

GPU还利用了指令级并行性。它可以同时执行多个不同类型的操作,如加法和乘法。这就像是一个多才多艺的艺术家,能够同时进行绘画、雕塑等多种创作活动。

四、实际应用案例

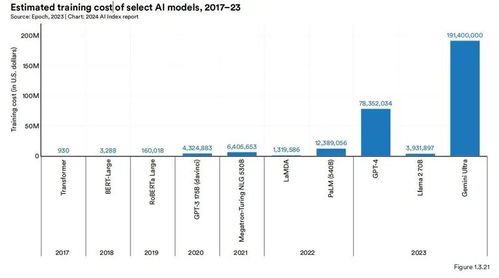

在深度学习领域,GPU已经成为不可或缺的工具。神经网络训练过程中涉及大量的矩阵运算,这对计算资源提出了很高的要求。使用GPU可以大大缩短训练时间,使研究人员能够更快地进行实验和创新。例如,AlphaGo的成功离不开GPU的强大支持。

除了深度学习,GPU还在物理模拟、金融建模等领域发挥着重要作用。在电影特效制作中,GPU可以帮助生成逼真的场景效果;在金融市场分析中,它能够快速处理海量数据,为投资者提供决策依据。

五、未来展望

随着技术的不断进步,GPU的能力也在不断提升。新型架构、更高效的编程模型以及与其他硬件的协同工作将使GPU的应用范围更加广泛。作为普通用户,我们或许不需要深入了解这些复杂的原理,但了解GPU背后的故事,能让我们更好地欣赏科技的魅力。

总之,通过这次对GPU并行计算的学习之旅,我对计算机世界的理解又深了一层。希望这篇文章也能激发更多人对这一领域的兴趣,共同探索未知的世界。

发表评论 取消回复