在这个科技日新月异的时代,AI技术的发展速度令人瞩目。而最近,斯坦福大学的李飞飞教授带领她的团队再次震撼了整个AI界。他们仅用了不到50美元的成本,就成功训练出了一款性能卓越的新模型,这一成果不仅为科研人员带来了希望,更让全球对AI技术的未来充满了无限遐想。

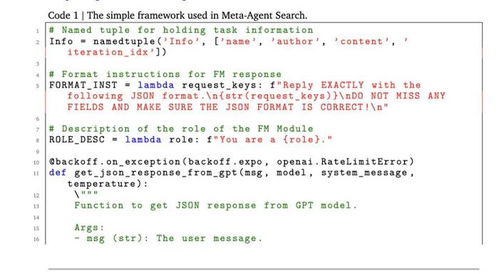

让我们走进这个故事的核心,看看李飞飞教授是如何实现这一惊人成就的。李飞飞教授及其团队开发的新方法被称为s1,它是一种最简化的测试时间扩展(test-time scaling)方法。通过这种方法,研究人员只需让模型训练大约1000个问题,就能获得超越传统模型o1的强大推理能力。这种高效且经济实惠的方法,无疑为AI领域的研究开辟了新的道路。

李飞飞教授在接受采访时表示:“我们一直在寻找一种既简单又有效的解决方案,以降低AI模型训练的成本。s1方法的成功证明了,有时候并不需要复杂的算法或庞大的数据集,只要找到合适的切入点,就能取得意想不到的效果。”

事实上,在过去几个月里,AI领域已经见证了一系列重要的进展。例如,DeepSeek团队推出了全新开源模型DeepSeek-R1,该模型在GitHub上迅速获得了4k+star的关注;OpenAI也宣布推出新一代推理模型o3系列的mini版本,这款模型以其强大的处理能力和较低的成本受到广泛关注。

然而,与上述项目相比,李飞飞团队的研究成果更加引人注目。因为他们在保证模型性能的前提下,极大地降低了训练成本。这对于那些资源有限的研究机构和个人开发者来说,无疑是一个巨大的福音。此外,这也意味着更多的人可以参与到AI技术的研发中来,从而推动整个行业更快地向前发展。

值得注意的是,尽管李飞飞团队取得了如此辉煌的成绩,但他们并没有因此而骄傲自满。相反,他们始终保持着谦逊的态度,并继续探索着未知的领域。正如李飞飞教授所说:“每一次的成功都只是新的起点,我们还有很长的路要走。”

为了更好地理解s1方法的工作原理,我们可以将其与其他现有技术进行对比分析。传统的AI模型通常需要大量的计算资源和时间来进行训练,这使得许多小型企业和个人开发者望而却步。而s1方法则巧妙地避开了这些问题,通过简化模型结构并优化参数设置,实现了快速高效的训练过程。

具体来说,s1方法采用了基于小样本学习的思想,即利用少量标注数据来引导模型学习到更为通用的知识表示。这样一来,即使是在数据量较少的情况下,也能确保模型具备良好的泛化能力。同时,为了进一步提高模型的表现,研究人员还引入了一些先进的正则化技术,如dropout、L2正则化等,这些措施有助于防止过拟合现象的发生,从而使模型能够在各种任务上表现出色。

当然,除了技术创新之外,李飞飞团队的成功还得益于其开放合作的精神。在整个项目过程中,他们积极与其他研究机构展开交流与合作,共同攻克了一个又一个难题。正是这种团结协作的力量,才使得s1方法得以顺利诞生。

展望未来,随着s1方法的不断推广和完善,相信它将会在更多应用场景中发挥重要作用。无论是自然语言处理、计算机视觉还是强化学习等领域,都将因这项新技术的到来而发生深刻变革。而对于广大科研工作者而言,s1方法所带来的不仅是技术上的革新,更是思维方式上的转变——那就是在追求高性能的同时,也要注重成本效益的最大化。

总之,李飞飞团队用不到50美元训练出的新模型,不仅展示了他们在AI技术研发方面的卓越实力,更为整个行业树立了一个典范。在未来的发展道路上,期待看到更多像李飞飞这样的科学家们,能够持续不断地为我们带来更多惊喜与突破!

发表评论 取消回复