大家好,我是小明,一个热爱编程的Python爱好者。今天,我将带大家一起探索如何在Python中安装和使用requests库,并通过实际操作来完成一些有趣的任务。这篇文章不仅会帮助你掌握requests库的基本用法,还会分享我在学习过程中遇到的一些问题和解决方法。

一、为什么要学习requests库?

requests库是Python中非常流行的HTTP库,它可以帮助我们轻松地发送HTTP请求,获取网页内容,处理响应数据等。无论是爬取网页、调用API,还是进行自动化测试,requests库都能派上大用场。相比其他HTTP库,requests库的语法更加简洁易懂,功能也更加强大。

二、准备工作

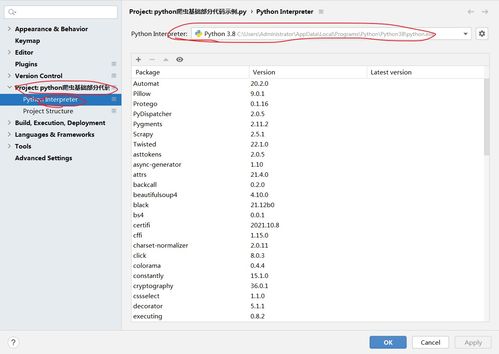

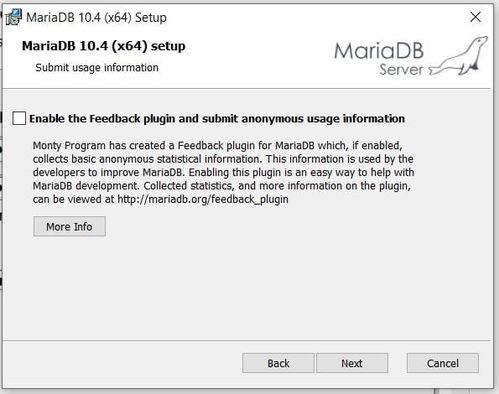

在开始安装和使用requests库之前,我们需要确保已经安装了Python环境。如果你还没有安装Python,可以访问Python官网下载并安装最新版本的Python。我使用的Python版本是3.6,因此接下来的操作将以Python 3.6为例。

三、安装requests库

1. **激活Python 3.6环境**

如果你使用的是Anaconda,可以通过以下命令激活Python 3.6环境:

conda activate python36这一步非常重要,因为它确保我们在正确的Python环境中安装和使用requests库。如果你没有使用Anaconda,可以直接在命令行中输入以下命令来安装requests库:

pip install requests2. **验证安装是否成功**

为了确保requests库已经成功安装,可以在Python交互式环境中导入该库并运行一个简单的测试:

import requests

response = requests.get('https://httpbin.org/get')

print(response.status_code)如果输出的状态码为200,说明安装成功!

四、requests库的基本用法

1. **发送GET请求**

GET请求是最常见的HTTP请求类型,通常用于获取资源。我们可以使用requests库中的get()方法来发送GET请求。例如,获取百度首页的内容:

import requests

url = 'https://www.baidu.com'

response = requests.get(url)

print(response.text)这里,response.text返回的是HTML格式的网页内容。如果你想查看响应头信息,可以使用response.headers属性:

print(response.headers)2. **发送POST请求**

POST请求通常用于提交数据,比如登录表单或上传文件。我们可以使用post()方法来发送POST请求。例如,向一个API提交用户信息:

import requests

url = 'https://api.example.com/login'

data = {'username': 'admin', 'password': '123456'}

response = requests.post(url, data=data)

print(response.json())这里,response.json()将返回的JSON数据解析为Python字典,方便我们进一步处理。

3. **处理参数和查询字符串**

有时候我们需要在URL中传递参数,比如分页、搜索关键词等。requests库提供了非常方便的方式来处理这些参数。例如,向百度搜索“requests库”:

import requests

url = 'https://www.baidu.com/s'

params = {'wd': 'requests库'}

response = requests.get(url, params=params)

print(response.url)这里,params参数是一个字典,表示要传递的查询参数。requests库会自动将这些参数拼接到URL中。

4. **处理Cookie和Session**

在某些情况下,网站可能会要求我们保持会话状态,比如登录后才能访问某些页面。requests库提供了一个Session对象,可以帮助我们管理会话。例如,模拟登录并访问需要登录的页面:

import requests

session = requests.Session()

login_url = 'https://example.com/login'

data = {'username': 'admin', 'password': '123456'}

session.post(login_url, data=data)

protected_url = 'https://example.com/protected'

response = session.get(protected_url)

print(response.text)这里,Session对象会自动保存登录后的Cookie,使得后续请求能够保持登录状态。

五、实战演练:爬取天气预报数据

现在我们已经掌握了requests库的基本用法,接下来让我们通过一个实战项目来巩固所学知识。我们将使用requests库爬取某网站的天气预报数据,并将其保存到本地文件中。

1. **确定目标网站**

首先,我们需要选择一个提供天气预报数据的网站。经过一番查找,我发现了一个名为“天气网”的API接口,它提供了全国各大城市的天气预报数据。API文档地址:天气网API。

2. **编写爬虫代码**

根据API文档,我们可以使用requests库发送GET请求,获取指定城市的天气预报数据。以下是完整的爬虫代码:

import requests

import json

import time

def get_weather(city_code):

url = f'https://www.weather.com.cn/data/cityinfo/{city_code}.html'

response = requests.get(url)

if response.status_code == 200:

weather_data = response.json()['weatherinfo']

return weather_data

else:

print(f'Failed to fetch data for city code: {city_code}')

return None

def save_to_file(weather_data, filename='weather.txt'):

with open(filename, 'w', encoding='utf-8') as f:

f.write(f'城市: {weather_data[

发表评论 取消回复