在人工智能领域,最近发生了一件令人兴奋的事情。作为一名对AI技术充满热情的探索者,我有幸见证了这一历史性的突破——UCLA等研究团队通过纯强化学习(RL)成功复现了DeepSeek-R1模型的“啊哈时刻”。这不仅是技术上的巨大飞跃,更是对传统监督微调方法的一次颠覆性挑战。

从监督微调到无监督强化学习

近年来,大型语言模型(LLM)的推理能力成为了学术界和工业界的焦点。然而,大多数现有的模型仍然依赖于监督微调(SFT),这种方法需要大量的标注数据,不仅耗时而且成本高昂。而DeepSeek团队推出的DeepSeek-R1模型,则另辟蹊径,采用了一种全新的训练策略:通过强化学习与蒸馏技术相结合,大幅提升了模型的推理性能。

具体来说,DeepSeek-R1-Zero是一个完全基于大规模强化学习训练的模型,它没有经过任何监督微调阶段。这意味着,这个模型完全依靠自我学习来掌握复杂的推理任务。相比之下,DeepSeek-R1则在强化学习的基础上加入了一个监督微调阶段,以进一步优化语言混合和可读性问题。这种设计使得DeepSeek-R1在推理任务上的表现可以媲美甚至超越OpenAI的某些顶级模型。

“啊哈时刻”的背后

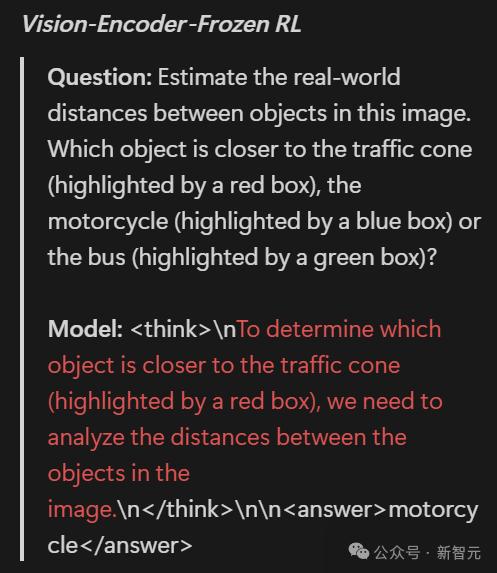

那么,什么是“啊哈时刻”呢?简单来说,这是指模型在处理复杂任务时突然展现出超越预期的能力。对于DeepSeek-R1而言,这一时刻发生在它能够准确理解并生成多模态内容的时候。例如,在面对一张图片和一段文字描述时,DeepSeek-R1不仅能正确解读两者的语义关系,还能生成连贯且富有逻辑的回答。这种能力的实现,标志着AI技术在多模态推理领域的重大突破。

更值得一提的是,UCLA的研究团队通过对DeepSeek-R1进行深入分析,发现其核心优势在于纯强化学习的训练方式。他们指出,传统的监督微调虽然能够提高模型的准确性,但同时也限制了模型的创造力和泛化能力。而强化学习则允许模型在自由探索中不断试错,从而找到最优解。

未来展望:AI的无限可能

作为一名亲历者,我深刻感受到这次突破的意义不仅仅局限于技术层面,它还为我们展示了AI未来的无限可能性。想象一下,如果我们可以摆脱对大量标注数据的依赖,那么AI的应用场景将变得更加广泛。无论是医疗诊断、自动驾驶还是教育辅助,都将因这项技术而受益。

当然,我们也必须清醒地认识到,尽管DeepSeek-R1已经取得了显著成果,但它距离完美还有很长的路要走。例如,在处理某些极端情况时,模型的表现仍存在波动。但这并不妨碍我们对其未来发展充满期待。

总之,这次由UCLA等研究团队带来的突破,让我们看到了AI技术的无限潜力。我相信,在不久的将来,我们将见证更多类似的奇迹发生。

发表评论 取消回复