在当今科技日新月异的时代,人工智能领域始终是人们关注的焦点。而最近,一篇微软的论文意外曝光了GPT模型的核心机密,引发了广泛讨论。今天,让我们跟随小明的脚步,一同揭开这神秘的面纱。

事件背景

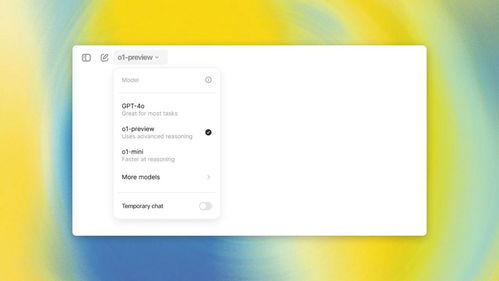

作为一名AI爱好者,小明一直密切关注着各大科技公司的动态。近日,他偶然在36KR平台上看到了一条热搜:4o-mini只有8B,o1也才300B,微软论文意外曝光GPT核心机密。这条消息瞬间引起了小明的兴趣,他决定深入挖掘这个话题。

探索之旅

小明首先查阅了这篇备受瞩目的微软论文。据论文介绍,研究人员发现了一种名为4o-mini的小型语言模型,其参数量仅为8亿(8B),却能在某些特定任务上表现出色。与此同时,另一个名为o1的模型参数量更是低至3亿(300B),却同样具备不俗的能力。这些发现打破了人们对大型预训练模型必须拥有海量参数才能实现高性能的认知。

然而,更令人震惊的是,该论文还揭示了一些关于GPT模型的秘密。众所周知,GPT系列是由OpenAI开发的强大语言模型,在自然语言处理领域取得了巨大成功。但这次曝光的信息表明,GPT的核心并不像外界想象中那么复杂,甚至可以说相对简单。这让小明不禁思考,难道我们一直以来对AI的理解存在偏差?

技术解析

为了更好地理解这一现象,小明请教了几位业内专家。通过交流,他了解到,近年来随着Transformer架构的发展,研究人员开始尝试构建更高效、更轻量化的模型。这些模型虽然参数量较少,但由于采用了先进的优化算法和独特的网络结构设计,依然能够取得优异的成绩。

以4o-mini为例,它利用了稀疏激活机制,即只在需要时激活部分神经元,从而减少了计算资源消耗;同时结合了知识蒸馏技术,将大型模型的知识迁移到小型模型中,使其具备更强泛化能力。至于o1,则是在数据预处理阶段进行了特殊优化,使得模型能够更好地捕捉文本特征。

而对于GPT来说,其核心优势在于大规模无监督预训练与微调相结合的方式。通过对海量语料库进行预训练,模型可以学习到丰富的语言规律;然后针对具体任务进行微调,进一步提升性能。不过,此次曝光的信息显示,在实际应用中,并不一定需要如此庞大的参数规模就能达到理想效果。

行业影响

这一发现无疑给整个AI行业带来了巨大冲击。一方面,它为中小企业提供了更多机会。过去由于缺乏足够资金和技术实力来构建超大规模模型,很多公司只能望洋兴叹;而现在有了这些轻量化解决方案,他们也可以参与到这场竞争当中。另一方面,这也促使大厂重新审视自身发展战略。或许未来我们会看到更多注重效率而非单纯追求参数量增长的研发方向。

未来展望

站在新的起点上,小明对未来充满了期待。他认为,随着研究不断深入,我们将见证更多创新成果涌现出来。无论是从理论层面还是工程实践角度出发,都有无限可能等待着我们去探索。而对于普通用户而言,这意味着更加便捷高效的智能服务即将成为现实。想象一下,在不久的将来,你只需向手机说出一句话,就能得到精准的回答或建议;或者当你遇到问题时,身边随时有一位聪明的助手为你出谋划策……这一切都离不开背后那些默默耕耘的技术人员们。

总之,这次微软论文所揭示的内容为我们打开了一个全新的视角。它告诉我们,在追求极致性能的同时,也要关注效率与成本之间的平衡。相信在不久的将来,AI技术将朝着更加健康可持续的方向发展,为人类社会带来更多福祉。

发表评论 取消回复