大家好,我是小明,一个热爱编程和科技的iOS开发者。最近,我一直在研究如何将Google的MediaPipe库集成到iOS项目中,以实现一些有趣的人脸检测和手势识别功能。今天,我想和大家分享一下我的学习和开发过程,希望对同样感兴趣的朋友们有所帮助。

一、为什么选择MediaPipe?

MediaPipe是Google推出的一个跨平台框架,主要用于处理多媒体数据,如图像、视频等。它不仅支持多种设备和操作系统,还提供了丰富的预训练模型和管道(pipeline),可以快速实现各种计算机视觉任务。对于iOS开发者来说,MediaPipe的iOS支持非常完善,官方文档和示例代码也非常详细,这让我决定深入研究这个工具。

二、初识MediaPipe

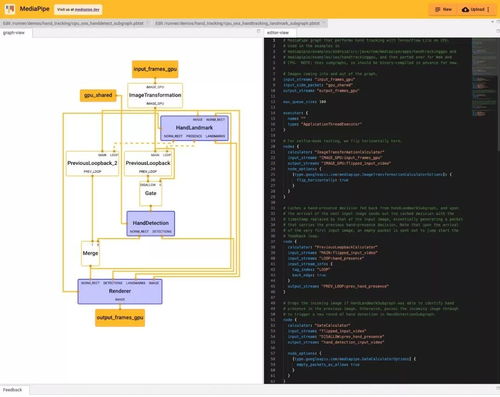

当我第一次接触MediaPipe时,说实话,感觉有点无从下手。毕竟,这是一个相对复杂的框架,涉及到了很多底层的技术细节。为了更好地理解MediaPipe的工作原理,我首先阅读了官方文档,并尝试运行了一些简单的示例项目。通过这些初步的探索,我逐渐掌握了MediaPipe的基本概念和使用方法。

三、集成MediaPipe到iOS项目

接下来,我开始尝试将MediaPipe集成到自己的iOS项目中。根据官方文档的指引,我首先在Xcode中创建了一个新的Swift项目,并通过CocoaPods安装了MediaPipe的依赖库。安装完成后,我按照文档中的步骤,逐步配置了项目的构建设置和资源文件。经过一番努力,终于成功地将MediaPipe集成到了项目中。

四、实现人脸检测功能

集成MediaPipe后,我决定先实现一个人脸检测的功能。MediaPipe提供了一个名为Face Detection的预训练模型,可以直接用于检测图像或视频中的人脸。为了调用这个模型,我编写了一段简单的代码,加载了MediaPipe的图形文件,并将其应用于相机捕获的实时视频流。经过几次调试,最终实现了稳定的人脸检测效果。看着屏幕上准确识别出的人脸框,我感到非常兴奋。

五、优化性能与用户体验

虽然人脸检测功能已经实现,但在实际使用中,我发现了一些性能问题。例如,当处理高分辨率视频时,检测速度会明显下降,导致用户体验不佳。为了解决这个问题,我查阅了苹果的官方文档(Apple Documentation),并参考了一些性能优化的最佳实践。通过调整模型的参数和优化代码逻辑,我成功提高了检测的速度和稳定性。此外,我还加入了一些用户界面的改进,如添加了检测结果的可视化效果和反馈提示,使得整个应用更加友好。

六、探索更多功能

在实现了人脸检测功能后,我对MediaPipe的兴趣愈发浓厚。于是,我继续探索了其他功能,如手势识别、姿态估计等。MediaPipe提供了多个预训练模型,可以轻松实现这些复杂的功能。通过不断学习和实践,我逐渐掌握了MediaPipe的更多高级特性,并在我的项目中实现了多种计算机视觉应用。

七、遇到的问题与解决方案

在开发过程中,我也遇到了不少挑战。例如,MediaPipe的某些功能在iOS上可能会遇到兼容性问题,或者需要额外的配置才能正常工作。每当遇到这些问题时,我会首先查阅苹果的官方文档(Apple Documentation),因为这是最权威和可靠的资源。如果文档中没有找到答案,我也会参考Stack Overflow和Google上的相关讨论,寻找解决方案。通过不断积累经验,我逐渐克服了这些难题,提升了开发效率。

八、总结与展望

通过这次MediaPipe的学习和开发,我不仅掌握了一项强大的技术,还深刻体会到了持续学习的重要性。MediaPipe作为一个开源框架,拥有丰富的功能和灵活的扩展性,非常适合用于开发各种多媒体应用。未来,我计划继续深入研究MediaPipe的更多高级特性,并将其应用于更多的项目中。同时,我也希望能够与更多的开发者交流经验,共同进步。

如果你也对MediaPipe感兴趣,不妨试试看吧!相信你一定会发现它的魅力所在。最后,感谢大家的阅读,如果有任何问题或建议,欢迎在评论区留言讨论。

发表评论 取消回复