在当今信息爆炸的时代,小李每天都要面对大量的文本数据。无论是从简书平台获取的热搜内容,还是日常工作中需要整理的文档,这些文本往往存在重复、冗余的问题。为了解决这一痛点,他开始探索一种高效的方法来批量整合文本,并实现智能去重。

### 一、问题的起源

作为一名自媒体创作者,小李深知优质内容的重要性。然而,当他试图将多个来源的文本进行整合时,却发现其中充满了大量重复的信息。这不仅浪费时间,还容易导致内容质量下降。于是,他决定寻找一种工具或方法,能够帮助他快速完成文本的整合与去重。

### 二、解决方案的探索

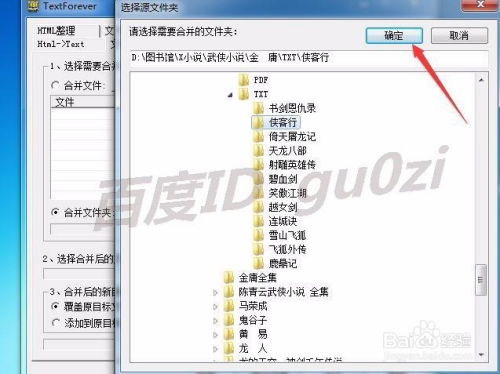

经过一番研究,小李发现了一些非常实用的工具和技术。首先,他尝试使用Python编写了一个简单的脚本,用于批量读取TXT文件并合并成一个整体文档。代码的核心逻辑如下:

import os

def merge_txt_files(folder_path, output_file):

with open(output_file, 'w', encoding='utf-8') as outfile:

for filename in os.listdir(folder_path):

if filename.endswith('.txt'):

with open(os.path.join(folder_path, filename), 'r', encoding='utf-8') as infile:

outfile.write(infile.read())

通过这段代码,小李成功地将所有TXT文件的内容整合到了一个文件中。接下来,他需要解决的是如何去重。

### 三、智能去重的实现

为了实现智能去重,小李引入了自然语言处理技术。他利用Python中的NLTK库和spaCy库对文本进行分词和句子分割,然后通过计算句子之间的相似度来判断是否重复。具体步骤如下:

- 加载文本数据;

- 对文本进行分句处理;

- 计算每两个句子之间的相似度(可以使用余弦相似度或其他算法);

- 根据设定的阈值筛选出不重复的句子。

这种方法虽然需要一定的编程基础,但对于像小李这样的技术爱好者来说并不算困难。最终,他成功实现了文本的智能去重。

### 四、指定位置存储TXT文件

解决了整合与去重的问题后,小李还需要将最终生成的TXT文件保存到指定位置。为此,他在代码中加入了路径设置的功能。例如:

output_folder = '/path/to/output'

if not os.path.exists(output_folder):

os.makedirs(output_folder)

output_file = os.path.join(output_folder, 'final_output.txt')

这样一来,他可以轻松地将结果文件存放到自己指定的目录下。

### 五、总结与展望

通过以上步骤,小李不仅提高了工作效率,还大大提升了内容的质量。他感慨道:“以前处理文本总是费时又费力,现在有了这些工具和技术的帮助,一切都变得简单多了。”

当然,这只是文本处理领域的一小部分。未来,随着人工智能技术的不断发展,相信会有更多高效的工具出现,帮助我们更好地应对海量信息的挑战。

发表评论 取消回复