在大数据的浪潮中,日志采集已经成为每个开发者绕不开的话题。今天,我想和大家分享一个让我受益匪浅的技术工具——Flume。作为一名初入职场的程序员,我第一次接触Flume时,内心充满了好奇与挑战。

什么是Flume?简单来说,Flume是一个分布式、可靠且高效的数据收集系统,主要用于将大量日志数据从不同来源传输到中心存储系统中。听起来很复杂?其实不然!当我深入了解它的架构后,发现它就像一条高效的流水线,把分散的日志数据源源不断地输送到指定的目的地。

初识Flume

记得那是去年的一个项目,我们的团队需要搭建一套完整的日志采集方案。当时,市面上有很多选择,比如Logstash、Kafka等,但最终我们选择了Flume。原因很简单:Flume具有高度可扩展性和容错能力,非常适合处理大规模的日志数据。而且,它的配置相对简单,即使是新手也能快速上手。

刚开始使用Flume时,我遇到了不少问题。例如,如何正确配置Agent?如何优化数据传输性能?这些问题一度让我感到困惑。但幸运的是,Flume社区非常活跃,通过查阅官方文档和参考其他开发者的经验,我逐渐掌握了它的核心原理。

深入探索

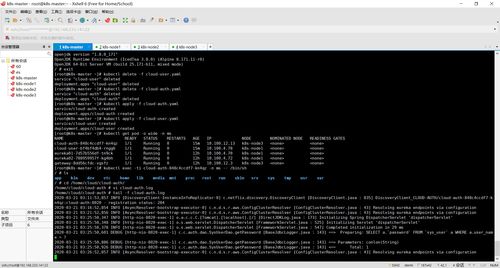

随着对Flume的理解加深,我发现它不仅仅是一个简单的日志采集工具,更是一套灵活的数据流管理框架。Flume支持多种Source(数据源)、Channel(通道)和Sink(目标),可以根据实际需求自由组合。例如,在我们的项目中,我们使用了Avro Source来接收远程客户端发送的日志数据,并通过File Channel将数据暂存到本地磁盘,最后通过HDFS Sink将数据写入Hadoop集群。

此外,Flume还提供了强大的插件机制,允许开发者根据自己的需求定制功能。这种灵活性让我深刻体会到开源技术的魅力所在。

实战中的应用

在实际应用中,Flume的表现令人印象深刻。我们的系统每天需要处理数百万条日志记录,而Flume始终保持着稳定的运行状态。即使在网络波动或硬件故障的情况下,它也能自动恢复并继续传输数据。这种可靠性为我们的业务提供了强有力的保障。

当然,任何技术都不是完美的。Flume也有它的局限性,比如对内存的占用较高,以及在高并发场景下可能出现性能瓶颈。不过,这些都可以通过合理的配置和优化来解决。

总结与展望

回顾这段学习Flume的经历,我不仅掌握了一项重要的技术技能,更重要的是培养了解决问题的能力。未来,我希望能够在大数据领域继续深耕,探索更多先进的技术和工具。如果你也对Flume感兴趣,不妨亲自尝试一下吧!相信你一定会从中收获满满。

发表评论 取消回复