在2024年的科技浪潮中,MediaPipe作为一款强大的开源框架,逐渐成为开发者们的新宠。作为一名热衷于技术探索的开发者,我决定将MediaPipe与iOS平台进行集成,为自己的项目注入更多创新元素。

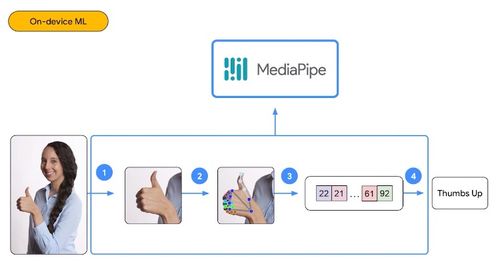

MediaPipe是由Google推出的一款多功能跨平台框架,它能够帮助开发者轻松实现计算机视觉和机器学习任务。而iOS作为一个高度活跃的生态系统,拥有庞大的用户群体和丰富的开发工具链。两者的结合无疑是一场技术盛宴。

第一步:环境搭建

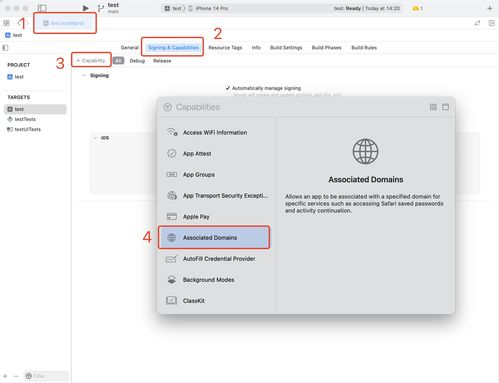

我的旅程始于环境搭建。为了确保MediaPipe能够在iOS平台上顺利运行,我首先需要安装Xcode以及CocoaPods等必要工具。经过一番摸索,我发现官方文档提供了详尽的指导,但实际操作时仍需注意一些细节问题,例如版本兼容性。通过不断尝试和调整,我终于成功配置好了开发环境。

第二步:功能实现

接下来就是激动人心的功能实现了!借助MediaPipe提供的丰富API接口,我开始着手开发手势识别模块。这一过程并非一帆风顺,在调试过程中遇到了不少挑战。比如如何优化模型性能以适应移动设备的硬件限制?又该如何处理实时数据流以保证用户体验流畅?这些问题都需要深入思考并逐一攻克。

幸运的是,社区的力量是无穷的。在GitHub上,我找到了许多优秀的开源项目作为参考,并从中汲取灵感。同时,我也积极参与讨论区交流心得,与其他开发者共同成长。

第三步:测试与优化

当初步完成代码编写后,进入到了关键的测试阶段。通过对不同机型进行全面测试,发现了部分低配设备存在卡顿现象。于是我对算法进行了进一步优化,采用了轻量化模型替代原有复杂结构,并调整了参数设置以提高运行效率。

此外,我还特别注重用户体验方面的问题。例如界面设计是否友好、交互逻辑是否清晰等细节之处都经过反复打磨,力求做到尽善尽美。

总结与展望

回顾整个MediaPipe iOS集成的过程,虽然充满挑战但也收获满满。不仅提升了自身技术水平,更重要的是见证了技术创新带来的无限可能。未来,我将继续关注这一领域的发展动态,努力探索更多应用场景,为推动科技进步贡献自己的一份力量。

发表评论 取消回复