作为一名数据工程师,我一直对实时数据处理充满兴趣。最近,我有幸深入研究了Flink CDC(Change Data Capture)技术,用于将MySQL中的数据实时同步到Kafka。这一过程不仅让我掌握了Flink CDC的核心原理,还让我在实际项目中积累了宝贵的经验。今天,我想和大家分享一下这段旅程,希望对同样感兴趣的朋友们有所帮助。

一、初识Fink CDC

Flink CDC是Apache Flink的一个扩展库,它能够捕获数据库中的增量变更,并将其实时传输到其他系统中。相比于传统的ETL工具,Flink CDC的最大优势在于它可以实现无锁读取和低延迟的数据同步,这对于需要高并发和实时性的应用场景来说尤为重要。

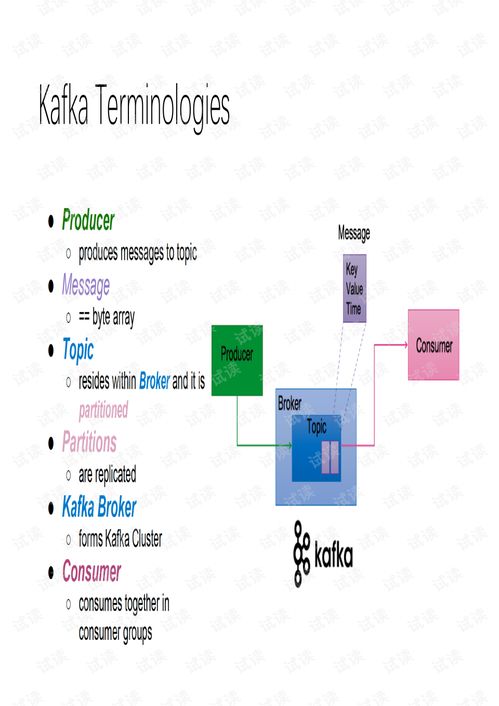

最初接触Flink CDC时,我对其工作原理并不十分了解。通过查阅官方文档和一些社区资料,我逐渐明白了它是如何工作的。简单来说,Flink CDC通过监听MySQL的binlog日志,捕获每一条插入、更新或删除操作,然后将这些变更事件转换为结构化的消息,最终发送到Kafka中。这个过程看似简单,但背后涉及的技术细节却相当复杂。

二、搭建环境与配置

为了验证Flink CDC的实际效果,我决定在一个小型项目中进行实验。首先,我需要准备一个MySQL数据库,并确保启用了binlog功能。接着,我安装了Flink集群,并配置了Kafka作为目标存储系统。最后,我下载了Flink CDC的JAR包,并将其添加到Flink的任务中。

在配置过程中,我遇到了一些问题。例如,MySQL的binlog格式选择不当会导致无法正确捕获变更事件;Kafka的Topic配置不合理会影响数据的分发效率;Flink任务的并行度设置不当时,可能会导致性能瓶颈。经过多次调试和优化,我终于找到了一套适合我项目的最佳配置方案。

三、实战中的挑战与解决方案

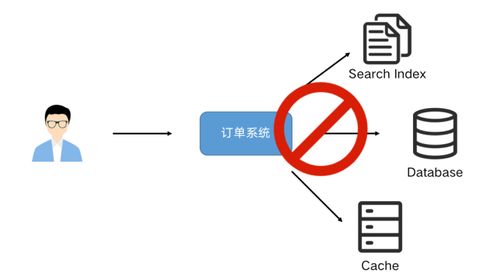

在实际使用Flink CDC的过程中,我遇到了不少挑战。首先是数据一致性问题。由于MySQL和Kafka之间的网络延迟,偶尔会出现数据丢失或重复的情况。为了解决这个问题,我引入了幂等性设计,确保每条消息只会被处理一次。同时,我还启用了Kafka的事务机制,保证了数据的一致性和可靠性。

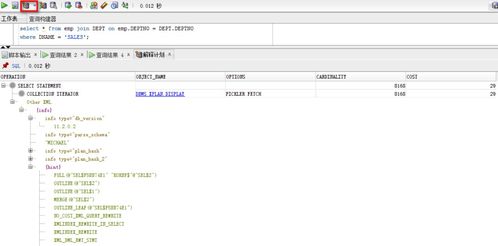

其次是性能优化。随着数据量的增加,Flink CDC的处理速度逐渐变慢。为此,我采取了多项优化措施。一方面,我调整了Flink任务的并行度,使其能够充分利用集群资源;另一方面,我优化了Kafka的Producer和Consumer配置,减少了网络传输的开销。此外,我还对MySQL的表结构进行了优化,减少了不必要的索引和字段,提升了查询效率。

四、总结与展望

通过这次项目实践,我对Flink CDC有了更深入的理解。它不仅能够实现高效的数据同步,还能应对复杂的业务场景。未来,我计划进一步探索Flink CDC与其他大数据组件的集成,如HBase、Elasticsearch等,以构建更加完善的实时数据处理平台。

总的来说,Flink CDC是一个非常强大的工具,特别适合那些需要实时处理大规模数据的应用。如果你也对实时数据处理感兴趣,不妨尝试一下Flink CDC,相信它会给你带来意想不到的惊喜。当然,在实际应用中,我们还需要不断学习和积累经验,才能更好地应对各种挑战。

发表评论 取消回复