昨天,在IT圈掀起了一阵热潮。美团搜推机器学习团队正式发布了其最新的开源成果——INT8无损满血版DeepSeek R1模型。作为一名对技术充满热情的探索者,我第一时间关注了这个消息,并深入研究了背后的细节。

为什么INT8量化如此重要?

在人工智能领域,模型量化是一种非常重要的技术手段。它通过降低模型权重的精度来减少计算资源的需求,同时尽量保持模型性能不下降。DeepSeek R1原生版本使用的是FP8数据格式,这种格式对硬件的要求极高,只有英伟达新型GPU(如Ada、Hopper架构芯片)才能支持。然而,这样的限制使得许多企业和开发者无法充分利用这一强大的模型。

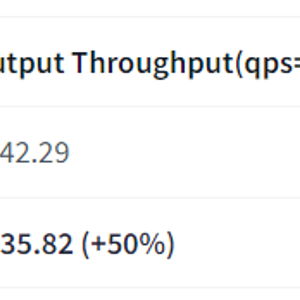

美团团队的创新之处在于,他们成功地将DeepSeek R1模型进行了INT8精度量化,不仅基本无损地保留了模型性能,还极大地扩展了其适用范围。这意味着,即使是像A100这样相对“老一代”的GPU,也可以高效运行该模型,从而实现50%的吞吐量提升。

技术实现的背后

作为技术爱好者,我对美团团队的技术实现过程充满了好奇。根据公开资料,他们采用了SGLang框架来进行模型量化。SGLang是一个灵活且高效的工具,能够很好地平衡模型精度与计算效率之间的关系。

具体来说,美团团队首先对DeepSeek R1模型进行了细致的分析,识别出哪些部分可以安全地进行量化,哪些部分需要保持较高的精度。然后,他们利用SGLang框架中的优化算法,对模型进行了逐层调整和验证,确保最终输出的结果与原始模型相差无几。

此外,美团团队还开源了整个项目,这为社区提供了宝贵的参考价值。开发者们可以通过研究他们的代码,学习如何在自己的项目中应用类似的量化技术。

实际应用与未来展望

从实际效果来看,INT8无损满血版DeepSeek R1模型的表现令人印象深刻。在部署到A100 GPU后,模型的吞吐量提升了50%,这对于大规模应用场景来说是一个巨大的进步。例如,在推荐系统、搜索引擎等领域,这种性能提升可以直接转化为用户体验的改善和运营成本的降低。

更进一步地说,美团的这项成果不仅仅是一次技术上的突破,更是对整个AI行业的一次推动。通过降低硬件门槛,更多的企业和开发者可以参与到大模型的研究与应用中,共同推动AI技术的发展。

总结

总的来说,美团搜推机器学习团队的这次开源发布,无疑是AI领域的又一里程碑事件。它不仅展示了中国企业在技术创新方面的实力,也为全球开发者提供了一个优秀的范例。作为一名技术爱好者,我对此感到由衷的兴奋,并期待看到更多类似的技术突破。

发表评论 取消回复