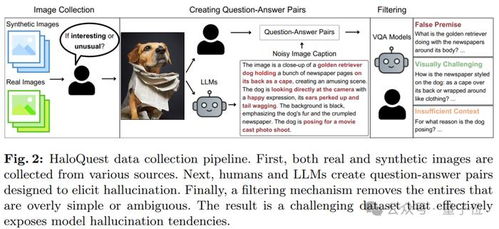

在当今科技飞速发展的时代,AI技术正在以前所未有的速度改变着我们的生活。然而,随着AI生成内容的普及,一个令人担忧的问题逐渐浮现——AI是否真的能够准确无误地解读信息?最近,谷歌和哥伦比亚大学的研究团队发布了一项引人注目的研究,揭示了AI“看图说谎”的现象,并提出了一种全新的动态评估框架,以应对这一挑战。

为了更好地理解这项研究的意义,让我们先从一个简单的例子入手。想象一下,当你向AI展示一幅图片时,它可能会根据自己的算法逻辑编造出一些并不存在的信息。这种现象被称为“幻觉”,即AI生成的内容与实际输入之间存在偏差。而谷歌与哥大的研究正是围绕这一问题展开,试图通过设计三类陷阱来测试AI的表现。

点击跳转到“什么是AI‘看图说谎’?”

第一类陷阱是“模糊边界”。在这种情况下,研究人员会故意提供一些模棱两可的图像,例如半遮挡的物体或光线不足的场景。这些图像要求AI必须进行推理才能得出结论。然而,许多AI模型往往会选择错误的答案,甚至编造出完全不符合事实的描述。这表明,当前的AI系统在处理不确定性时仍然存在较大的局限性。

点击跳转到“第一类陷阱:模糊边界”

第二类陷阱则是“误导性线索”。这类测试中,研究人员会在图像中加入一些看似相关但实际上具有误导性的元素。例如,在一张草原上的照片中添加一只不属于该环境的北极熊。结果发现,部分AI模型会因为这些误导性线索而产生错误判断,从而进一步证明了它们对上下文的理解能力尚显不足。

点击跳转到“第二类陷阱:误导性线索”

第三类陷阱被称为“对抗样本”。这是指通过微小但精心设计的改动,使AI模型对原本熟悉的图像产生完全错误的识别结果。例如,在一张猫的照片上添加一些人类难以察觉的噪声点,就可能让AI将其误认为是狗。这种现象不仅揭示了AI系统的脆弱性,也为未来的技术改进提供了重要方向。

点击跳转到“第三类陷阱:对抗样本”

基于以上三种陷阱的测试结果,谷歌与哥大共同提出了一种动态演进的评估框架。这一框架的核心理念在于,随着AI技术的不断发展,评估标准也需要随之调整,以确保其始终能够适应最新的技术特点。具体而言,该框架包括以下几个关键要素:

- 实时更新:根据最新研究成果和技术进展,定期优化评估指标。

- 多维度考量:不仅关注AI的准确性,还考虑其鲁棒性、公平性和透明度。

- 用户参与:鼓励更多开发者和研究人员参与到评估过程中,共同推动AI技术的进步。

对于个人而言,这项研究无疑为我们敲响了一记警钟。尽管AI技术已经取得了显著成就,但其潜在风险也不容忽视。在未来,我们需要更加谨慎地对待AI生成的内容,同时积极参与到相关技术的改进中去。只有这样,我们才能真正实现AI为人类服务的目标。

发表评论 取消回复